作者|鹿尧

前两天商汤在上海临港AIDC举办了一场大会,在大模型遍地、AI满天飞的当下,这次发布的日日新大模型5.0版本,以及配套或衍生的行业大模型和AI助手,仍然成为了行业焦点。

值得一提的是,这场发布会更像是一次关于行业技术的交流会,现场来给商汤站台的大厂非常多:华为、金山办公、小米、阅文等等,从业务介绍,到实战演练,透露出一家老牌科技公司的扎实和锐利。

众所周知,在万物都朝着智能化发展的时代,大模型凭借强大的表达和预测能力,涵盖自然语言处理、计算机视觉等多个领域,能够处理复杂的任务和数据。而以OpenAI作为代表的成功范例在全行业掀起的巨浪,更足以让人们相信大模型技术的可行性和市场潜力。

但随着技术的不断深入,不同场景对大模型的需求差异日益显现,人们发现,尤其是对手机、AR等终端、及汽车在内的智能体系来说,出于对轻量敏捷、安全稳定和成本等方面的考虑,传统的大模型似乎并不能满足他们的需求。

也就在这种情况下,端侧大模型逐渐成为新的行业趋势。

以手机为例,过去的一年里,国内外包括苹果、三星、华为、VIVO等大部分的手机厂商,都在研究一门新的学问:怎么将大模型落地到端侧?而他们之所以这么做,目的也很明确,既为了在行业瓶颈掌握市场突破的重要筹码,又为了满足用户AI需求,带来革新终端的使用体验。

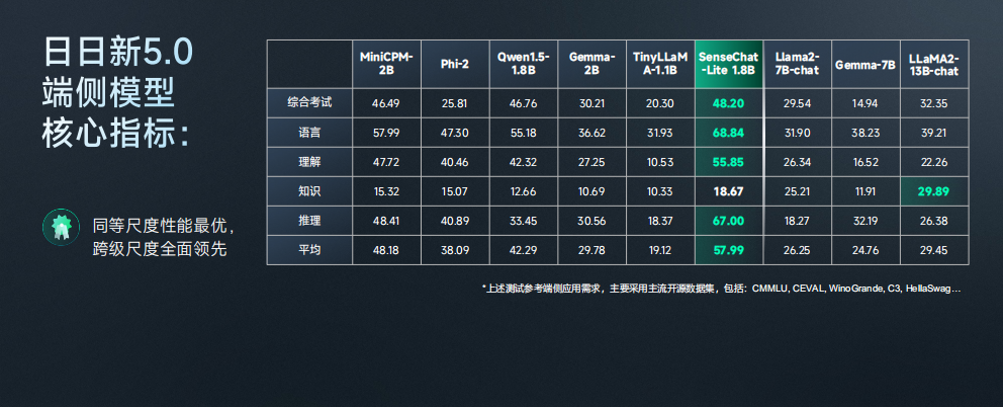

这也是此次商汤发布会被讨论最多的点。据了解,商汤新推出的1.8B(18亿)参数规模的 SenseChat-Lite版本端侧⼤模型,在基准测试中,全面超越了MiniCPM-2B、Phi-2等所有开源的同量级的大模型,甚至越级比肩一些7B、13B的大模型,性能、指标非常硬核。

更直观的例子,是现场演示的SenseChat-Lite与GPT-4的一场拳皇比赛,就像商汤董事长兼CEO徐立说的那样,“天下武功,唯快不破。”在不同的适用场景下,小模型决策更快,不管拳是不是最优的,但都实实在在地打到了对手的身上。

有意思的是,发布会的第二天,商汤的股价即迎来开盘大涨,一度涨超36%,周涨超80%,创上市后单周最大涨幅。不少人认为,这可能就是市场给予这家公司最直接的肯定。

01

端侧大模型元年

在手机上使用AI大模型其实并不是新鲜事了。

ChatGPT上线之后,国内的科技互联网圈一度处在你追我赶的状态,不到一年的时间里,文心一言、通义千问、讯飞星火等等都接连推出App应用。彼时人们的关注点大多在于,哪款产品的回复准确率更高,以及它怎么实现可持续的商业化。

不难发现,当AI的概念总以第三方应用的形式被植入手机时,人们的关注点仍聚焦软件本身,但并不会因此对某款手机产生新的认知。

大模型可以被称为一种暴力美学,一般认为,目前主流云端大模型的参数量在千亿级别,算法性能随着训练时长和数据集的增加而增长。这些基于云端大模型的App,需要调用海量的服务算力来进行数据传输,成本和安全性是服务商不能回避的问题。

此前有手机厂商透露,调用一次云端大模型的平均成本在1.2分到1.5分人民币,假设每个品牌都有上亿的用户量,每人每天调用10次,那么积攒下来的算力成本是惊人的;如果按次数或月租向用户进行收费,在功能同质化的情况下,用户的使用意愿也会很难保证。

而用户更加关注的是,喂给的数据从何而来、用到哪里去,信息储存在云端是否可靠,会不会有更多风险?

这样一来,手机厂商开始研究起大模型,由此“AI手机”的概念再度火热。虽然彼时谁都不知道AI手机究竟是什么样,不过可以肯定,联网使用某款App获得的单一体验绝不是最终的答案。

为了解决大模型算力和用户数据安全的问题,手机厂商们选择将大模型部署在本地,利用芯片算力生成结果,不用联网也能使用。毕竟云端大模型的参数规模,内存、算力和功耗的需求都是一部手机满足不了的,端侧的大模型,参数可以压缩到数十亿到百亿左右,但性能上仍然抗打。

但事实上,这将是更大的挑战,和坐拥数千张顶级显卡的大模型公司相比,手机厂商走端侧路线,意味着要在更小的芯片空间里,做出不逊于超级大模型的产品。

理想状态,每款手机都将成为给每个人量身定制的私人AI助手。就像商汤发布会上徐立演示的,在完全断网的状态下,商汤端侧大模型输出一张请假条的速度,甚至比人们阅读的速度还快很多;模拟在飞行模式时,同样可以利用AI生成详细的工作纪要,且速度基本等同人眼实时的速度。

除此以外,商汤在端侧大模型的布局思路是多模态,也就意味着数据和信息可以来自不同的感官,生成结果除了文字,未来还可以是图片、视频等多种形式,这被他们称为“扩散模型”。

在徐立看来,端侧是行业应用铺开的关键,商汤的扩散模型实现业内最快的端侧推理速度,在高通旗舰平台上能够做到小于1.5秒。在端侧和云侧的对比扩图实验中发现,端侧连扩了三张图,云端还没有完成;端侧生成3个图,云端才完成1张图的扩图,此外还能够旋转扩图、任意比例扩图。

“端侧模型对于本地的处理有非常大的友好性。”徐立说,由于是直接在本地设备上运行,无需将数据发送到云端处理,这极大减少了数据传输和等待云端响应的时间。

从行业场景上看,目前商汤的端侧模型已经覆盖到日常对话、常识问答、文案生成、相册管理、图片生成等一系列功能,而这种低延迟性,使得端侧模型在未来处理实时性要求较高的任务时具有显著优势,例如自动驾驶、实时翻译等。

业内人士透露,作为国内最早做端侧大模型的技术公司,商汤在算法和模型方面具备深厚的技术积累,且能在硬件适配和芯片兼容等方面做出创新。

值得关注的是,其多模态端侧SDK不仅广泛适配至手机、电脑、VR、车载显示屏等多种硬件场景;还能够兼容众多芯片,还实现了全系列的高通8系列芯片兼容,包括7系列芯片,甚至扩展至MTK天玑芯片,这为大模型技术的落地应用提供了更广阔的空间。

02

市场需要怎样的端侧大模型解决方案?

王晓刚是商汤的首席科学家,也是旗下绝影汽车事业群的总裁,在他看来,今天大模型发展最重要的并不有多少家会留在市场,而是差异化在哪。“有哪些是有价值、但风险更高,别人没尝试过,没做出来的东西,这是商汤在发展大模型时的差异化思路。”

从去年开始,商汤与小米小爱建联,通过端侧的大模型来赋能小爱众多的终端用户。

据小米集团小爱的总经理王刚介绍,小爱同学现在的用户规模达到了1.3亿人,主要以手机为主,日交互次数超过2亿次,大模型在去年8月份首先在手机和音箱上开启内测,目前已积攒了900万的大模型用户,活跃用户次日留存更是增加了10%。

“小爱不只是语音助手,更是无所不在的AI智能助手。”大模型给小爱同学带来的3点升级,分别是对话能力、垂直领域专业的AI助手、NLP任务能力的提升。而在商汤大模型的加持下,小爱除了性能明显提升,在时间性能力上,结合搜索功能,能引入可靠信息来源,提升用户对内容真实性的信任程度。

对于特定的业务场景,技术团队对小爱升级的综合能力和细节处理有更高的要求,需满足时新性、品牌导向,且及时调整来适应产品的变化;同时,通过优化输出格式,达到简洁清晰、图文并茂的输出。简单来说,有了商汤大模型的加入,小爱正成为更成熟可靠,且更懂用户的智能助手。

去年9月,在大模型内测成功之后,小米硬件部门决定在终端和高端机器上全部用上大模型,手机和音响之外,汽车是另一个布局重点。

众所周知,今年小米su7发布的火热超出所有人预期,据王刚分享,“不同于生成图文,车上大模型是完全不一样的设计体验,因为驾驶员更专注前面的行驶场景,追求简洁交互,在这方面我们与商汤一起做车上大模型的适配。”

大模型的加入,让很多以往没有的车载功能实现从0到1,用户对车内小爱同学的关注也与日俱增。还有一个容易被忽视的点,如果说过去由于技术限制,大部分的车企都倾向模块化布局,那么商汤大模型能够带来的改变则是将这些一一打通,让汽车真正实现端侧整体的智能,这背后离不开它的兼容性和多模态特征。

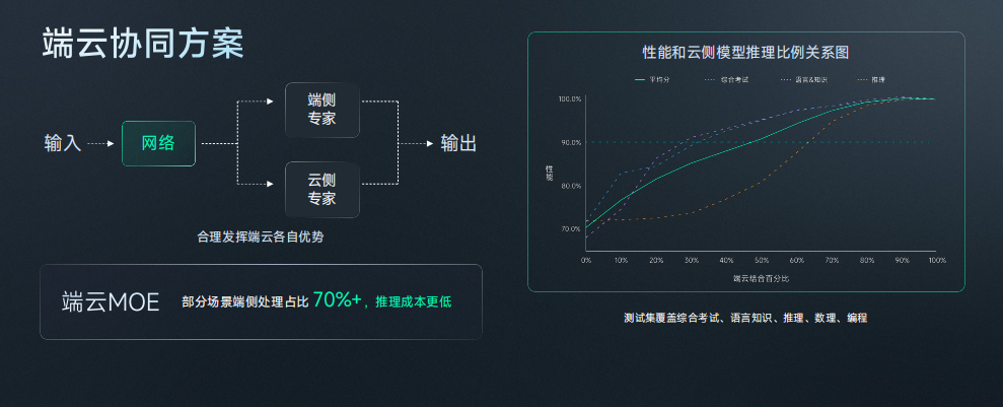

当然,也有很多人提出,比如手机,受限于当前GPU和NPU的硬件能力,大部分的终端仅能运行数十亿级别轻量级模型,但是这些模型训练参数较小,一定程度上会影响结果的精准输出。同样的问题可以延伸到不同的终端场景,于是,为了平衡内存、执行速度、功耗的问题,很多厂商提出了“端云协同”的需求。

背后的逻辑在于,用云侧解决复杂的大算力、大参数模型、实效性低的问题,用端侧满足数据安全性高、实时反馈、断网条件下的需求。对于商汤来说,这的确是大模型与场景协同的一次挑战,按照徐立的说法,大部分推理如果能在端侧100%完成的就完成,如果要追求高性能,就可以用端云联动的模式。

实用的模型往往能满足不同行业的差异化需求,这也是商汤重要的研发理念之一。为了达到最佳的推理效果,适配不同的业务场景,同时降低推理成本,他们提出了“端云协同方案”,针对不同行业应用设置了不同的云端联动百分比。

此前,王晓刚曾与媒体交流,“每年有30亿部手机,PC出货量一年有2-3亿台规模,AI PC可以成为我们每个人的助手,汽车智能化也处在重要的发展机遇期。”与商汤在端侧大模型展开合作的,已经覆盖了国内绝大部分的手机厂商和知名车企。现在可能到了大模型商业化普及和应用的最关键时期。

03

为什么是商汤?

“并不感到意外。”当天发布会现场,有投资人这么表述,作为一家成立之初就紧密围绕AI作为主要业务的科技公司,多年的技术沉淀,让商汤具备更成熟的能力做好大模型。

从个人终端到企业客户的基础设施,行业对AI的需求是多样的。2019年,商汤首次发布10亿参数视觉大模型,2022年发布320亿参数视觉大模型,到去年确立以“大模型+大算力”的发展战略,再加上旗下多款AI产品,商量、秒画、如影、琼宇、格物的多元布局,以及刚刚推出的全面对标GPT-4Turbo的日日新5.0等一系列创新。

可以说,商汤在科技圈里从未缺席,而这些成果的背后是十年如一日的持续投入。

据了解,2018年前后,商汤开始每年数十亿投入到专为AI原生打造的智算云服务平台“SenseCore”商汤大装置,并建设上海临港智算中心。

截至目前,大装置的总算力规模突破性增长到12,000 petaFLOPS,上线GPU数量高达45,000块GPU,其中临港AIDC为8400 petaFLOPS,远远超出立项规划的3740 petaFLOPS算力总量。

在算力和数据规模支持下,日日新大模型得以持续优化,但商汤的大装置不仅仅是为了支持自身的大模型研发,还作为算力服务方,支持外部客户训练大模型和应用部署:帮助自动化数据标注提升效率百倍,推理部署提高推理效率100%以上,微调和增量训练降低成本至原1/10,并提供开源模型和开发者工具,从而提升开发者效率。

目前,SenseCore已经成为国内稀缺的AI基础设施,且实现了全国联网的统一调度,在上海、深圳、广州、福州、济南、重庆等地拓展了新的计算节点。如果AI真的是未来社会进步和产业革新的关键力量,某种程度上,这也体现了商汤大装置的特殊点,它投入了很大的资源进行基础设施建设,赋能自身的同时反哺行业,将能力标准化、基础设施化、服务化,降低了整个人工智能产业创新的门槛。

时至今日,AI仍然是一个长周期,高成本投入,回报慢的行业,反倒是需要更多的战略定力。在商汤的生成式AI已经转向收入的快速回报之际,就像王晓刚说的那样,在商汤的背后,积累了大量对模型对AI的know-how,这些业务与行业的经验,或许也正在给AI结合不同产业的商业化落地提供了更具想象力的参考。